Guide ultime pour une Architecture d'Auto-Hébergement Souveraine et Sécurisée

L'auto-hébergement (self-hosting) ne consiste pas seulement à faire tourner des applications sur un serveur ; il s'agit de construire une forteresse numérique capable d'accueillir n'importe quel service rapidement, sans compromettre la sécurité ni la maintenabilité.

⚠️ Cet article est technique. Il s'adresse aux développeurs, admins sys et CTOs qui veulent comprendre comment architecturer une infrastructure self-hosted robuste et sécurisée.

Si le sujet vous parle mais que le jargon vous perd (Docker, Traefik, UFW...), c'est normal — et c'est exactement pour ça que mes offres packagées existent 🔥.

Je m'occupe de tout ça pour vous !

1. La renaissance de l'infrastructure auto-hébergée

À l'ère de l'informatique dans le cloud est omniprésente, où la commodité l'emporte souvent sur la confidentialité, l'auto-hébergement (ou self-hosting) émerge non plus comme un simple passe-temps pour technophiles, mais comme une nécessité stratégique pour garantir la souveraineté numérique.

S'affranchir des géants du web pour héberger ses propres services — de la gestion de fichiers avec Nextcloud (ou OpenCloud qui à ma préférence) à la publication web avec WordPress ou application web dernier cri — est un acte de reprise de contrôle.

Cependant, ce pouvoir implique une responsabilité critique : celle de l'architecte système. Contrairement aux environnements gérés (SaaS) où la sécurité est déléguée, l'auto-hébergement place l'administrateur en première ligne face à un internet hostile, saturé de bots, de scanners de vulnérabilités et d'acteurs malveillants.

Ce guide détaille une architecture de référence conçue pour l'hébergement robuste, flexible et sécurisé d'applications conteneurisées. Loin des configurations par défaut souvent perméables, je vous propose une approche "Zéro Confiance" (Zero Trust) appliquée au serveur unique. Cette stack technique repose sur une fondation immuable : un serveur dédié sous Debian Linux, orchestré par Docker, protégé par une isolation réseau stricte, et piloté par Traefik v3, un proxy inverse de nouvelle génération capable de gérer dynamiquement le trafic TCP et UDP tout en automatisant la sécurité cryptographique via des certificats Wildcard.

L'objectif de ce guide est de déconstruire chaque couche de cette infrastructure, d'en expliquer les mécanismes profonds, et de justifier chaque choix technique par des impératifs de sécurité et de maintenabilité. Nous explorerons comment transformer un simple serveur nu en une forteresse numérique, où chaque application vit dans son propre écosystème isolé, ne communiquant avec le monde extérieur que par des points d'entrée strictement contrôlés.

2. Le Socle de Confiance : Debian et le Durcissement du Système

Toute architecture logicielle, aussi sophistiquée soit-elle, hérite des vulnérabilités de son substrat. Dans notre cas, le système d'exploitation Debian (version Stable) a été choisi pour sa rigueur d'ingénierie et sa philosophie de stabilité, préférant des logiciels éprouvés aux versions "bleeding edge" potentiellement instables. Cependant, une installation standard de Debian n'est pas sécurisée par défaut pour une exposition directe sur l'internet public. Une phase de durcissement (hardening) est impérative avant même l'installation du premier conteneur Docker.

2.1. La Forteresse SSH : Repenser l'Accès Administratif

Le protocole SSH (Secure Shell) est la porte d'entrée universelle pour l'administration des serveurs Linux. Par conséquent, le port standard 22 est la cible la plus attaquée sur internet. Des réseaux de bots scannent continuellement l'espace d'adressage IPv4 à la recherche de serveurs exposant ce port, tentant des attaques par force brute sur des identifiants communs (root, admin, user).

2.1.1. L'Impératif de l'Authentification Asymétrique

La première mesure de défense consiste à éradiquer totalement l'authentification par mot de passe. Les mots de passe, même complexes, sont vulnérables à l'interception, au phishing, et à la force brute. À l'inverse, l'authentification par clé publique repose sur la cryptographie asymétrique. Je vous préconise l'utilisation de l'algorithme Ed25519, plus rapide et sécurisé que le RSA traditionnel, ou à défaut du RSA 4096 bits.

Dans cette configuration, le serveur ne possède que la clé publique ("le verrou"), tandis que l'administrateur détient la clé privée ("la clé"). Sans la clé privée, il est mathématiquement impossible de dériver l'accès, rendant les attaques par dictionnaire obsolètes. La configuration du démon SSH (/etc/ssh/sshd_config) doit refléter cette politique stricte :

PasswordAuthentication no ChallengeResponseAuthentication no UsePAM no PermitRootLogin no

L'interdiction du login root (PermitRootLogin no) ajoute une couche de sécurité et traçabilité essentielle : l'administrateur doit se connecter avec un compte utilisateur standard, puis élever ses privilèges via sudo, laissant ainsi une trace d'audit dans les journaux système (/var/log/auth.log) pour chaque action administrative.

2.1.2. Obscurcissement et Réduction de la Surface d'Attaque

Bien que la "sécurité par l'obscurité" ne soit pas une défense suffisante en soi, elle constitue une excellente mesure d'hygiène numérique. Déplacer le port SSH du 22 vers un port non standard (par exemple, dans la plage des ports éphémères comme 2244 ou 5022) réduit le "bruit de fond" des logs de plus de 99 %. Les scripts automatisés des attaquants opportunistes ciblent quasi exclusivement le port 22 pour maximiser leur retour sur investissement. En changeant de port, on s'exclut de facto de la grande majorité des campagnes d'attaque indifférenciées.

2.2. Le Pare-feu UFW : Stratégie de "Refus par Défaut"

Le pare-feu est le gardien des frontières du serveur. Sur Debian, UFW (Uncomplicated Firewall) offre une abstraction puissante pour gérer les tables de filtrage de paquets du noyau Linux (Netfilter/iptables). La philosophie de notre architecture est celle du Deny All Incoming : tout trafic entrant non explicitement sollicité doit être rejeté silencieusement.

2.2.1. Configuration de la Politique Restrictive

La mise en place commence par la définition des politiques par défaut : refuser tout en entrée, autoriser tout en sortie (pour permettre au serveur de faire ses mises à jour, contacter les serveurs DNS, etc.).

sudo ufw default deny incoming sudo ufw default allow outgoing

Cette politique garantit qu'un service démarré accidentellement sur le serveur (par exemple, une base de données de développement écoutant sur 0.0.0.0) restera inaccessible depuis l'extérieur, car aucun trou n'a été percé dans le pare-feu pour lui.

2.2.2. L'Ouverture Chirurgicale des Ports

Dans notre architecture basée sur un Reverse Proxy centralisé, la surface d'exposition est extrêmement réduite. Seuls trois ports doivent être ouverts au monde extérieur :

- Le Port SSH Personnalisé (ex: 2244 TCP) : Pour l'administration chiffrée.

- Le Port HTTP (80 TCP) : Exclusivement pour la redirection vers HTTPS. Aucun service ne doit répondre en clair sur ce port.

- Le Port HTTPS (443 TCP & UDP) : Le canal principal pour tous les services web et applicatifs. L'ouverture en UDP est nécessaire pour supporter le protocole HTTP/3 (QUIC), qui améliore considérablement la performance sur les réseaux instables (mobiles).

sudo ufw allow 2244/tcp comment 'SSH Administration' sudo ufw allow 80/tcp comment 'Traefik HTTP EntryPoint' sudo ufw allow 443/tcp comment 'Traefik HTTPS EntryPoint' sudo ufw allow 443/udp comment 'Traefik HTTP3/QUIC EntryPoint' sudo ufw enable

Cette configuration minimaliste contraste avec les approches traditionnelles où chaque service (Plex, Nextcloud, Gitlab) ouvrait son propre port (32400, 8080, etc.), créant un "gruyère" sécuritaire difficile à auditer. Ici, tout le trafic applicatif est multiplexé sur le port 443 et géré par Traefik.

2.2.3. L'Interaction Critique entre Docker et UFW

Il existe une subtilité technique majeure souvent ignorée : Docker, par défaut, manipule directement les règles iptables pour créer ses propres chaînes de routage (NAT). Ce faisant, il insère ses règles avant celles de UFW. Cela signifie qu'un conteneur configuré avec ports: - 8080:80 dans Docker Compose sera accessible depuis l'extérieur, même si UFW bloque le port 8080.

Pour contrer ce comportement sans casser la connectivité de Docker (ce qui arrive souvent en désactivant iptables dans le démon Docker), notre architecture adopte une règle d'or : Aucun port de conteneur applicatif n'est publié sur l'interface publique de l'hôte.

Les directives ports: sont proscrites pour les applications backend. Seul Traefik publie les ports 80 et 443. Les applications ne sont accessibles que via le réseau Docker interne, que nous détaillerons dans la section suivante. Cette approche rend le conflit Docker/UFW inopérant pour les services applicatifs, car ils n'essaient jamais de s'attacher à l'interface réseau de l'hôte.

3. L'Architecture Réseau Docker : Isolation et Segmentation

L'orchestration des conteneurs via Docker Compose est au cœur de cette proposition. Cependant, l'utilisation naïve de Docker Compose (où tous les services d'un fichier docker-compose.yml partagent un réseau default) recrée les problèmes de sécurité des réseaux plats ("flat networks") : si un conteneur est compromis, l'attaquant a un accès réseau direct à tous les autres conteneurs voisins (bases de données, caches, autres apps).

Pour garantir une sécurité en profondeur, nous structurons le réseau Docker selon une topologie stricte de Frontal Public et de Backends Isolés.

3.1. Le Réseau "Web" : La Zone Démilitarisée (DMZ)

Nous créons un réseau Docker explicite, nommé web (ou proxy), qui agit comme une dorsale de communication pour le trafic HTTP/TCP entrant.

- Rôle : Connecter le Reverse Proxy (Traefik) aux interfaces frontales des applications.

- Membres Autorisés : Uniquement Traefik et les conteneurs qui doivent recevoir du trafic web (ex: le conteneur wordpress, mais pas le conteneur mysql associé).

- Création : Ce réseau est déclaré comme "externe" dans les fichiers Docker Compose, signifiant qu'il est géré indépendamment du cycle de vie des applications.

docker network create web

3.2. Les Réseaux Applicatifs Dédiés : Le Principe de Moindre Privilège

Pour chaque application déployée (stack), nous définissons un réseau interne dédié qui n'est pas partagé avec d'autres stacks. C'est ici que réside la véritable isolation.

Prenons l'exemple d'une stack Nextcloud. Elle se compose généralement de trois services : le serveur web Nextcloud, une base de données MariaDB, et un cache Redis.

Dans notre architecture :

- Le service Nextcloud est connecté à deux réseaux :

- web : Pour recevoir les requêtes de Traefik.

- nextcloud_backend : Pour parler à sa base de données et son cache.

- Le service MariaDB est connecté uniquement à nextcloud_backend.

- Le service Redis est connecté uniquement à nextcloud_backend.

Conséquence Sécuritaire : Traefik (et par extension, internet) n'a aucune route réseau vers la base de données MariaDB. De même, si la stack d'à côté (disons, un blog WordPress) est compromise, le conteneur WordPress ne peut pas attaquer la base de données Nextcloud car ils ne partagent aucun réseau commun. Le réseau web sert uniquement de transit pour le trafic HTTP vers les frontaux, mais ne permet pas d'atteindre les couches de persistance.

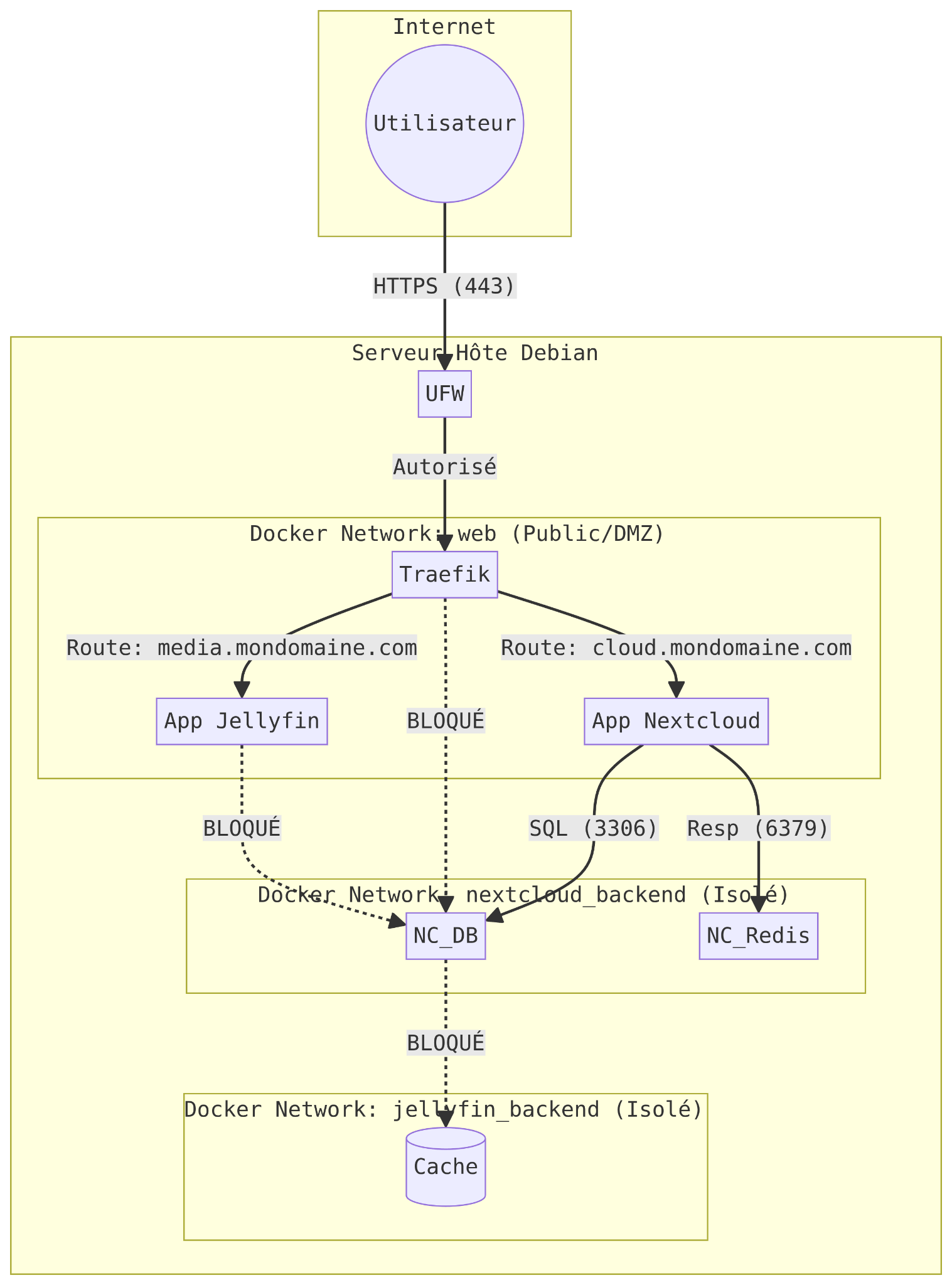

3.3. Visualisation de la Topologie Réseau

Le diagramme suivant illustre cette ségrégation stricte des flux, essentielle pour contenir les incidents de sécurité ("Blast Radius Containment").

3.4. Philosophie "Shared-Nothing" : Contre les Services Partagés

Une tentation fréquente en auto-hébergement est de mutualiser les ressources : monter un seul gros serveur Redis ou une seule instance MariaDB pour servir tous les conteneurs, dans un souci d'économie de mémoire RAM.

Nous déconseillons formellement cette approche pour des raisons de "Séparation de Responsabilité" (Separation of Concerns).

- Isolation des Pannes : Si un Redis partagé plante ou est saturé par une application gourmande, toutes les applications de l'infrastructure tombent simultanément (SPOF - Single Point of Failure). Avec des instances dédiées, le crash du Redis de Nextcloud n'affecte pas le Redis de Gitlab.

- Sécurité des Données : Dans un modèle partagé, une mauvaise configuration applicative pourrait permettre à l'App A de lire (ou pire, d'écraser via la commande FLUSHALL) les données de cache de l'App B. L'isolation par conteneur garantit que chaque application ne voit que ses propres données.

- Gestion des Versions : Une application peut nécessiter MariaDB 10.6 tandis qu'une autre exige MariaDB 11.4. Un serveur de base de données partagé force des compromis de versioning complexes et risqués. L'approche conteneurisée permet à chaque stack de choisir sa version exacte de dépendance.

4. Traefik v3 : Le Chef d'Orchestre du Trafic

Traefik est la clé de voûte de cette architecture. Contrairement aux proxys traditionnels comme Nginx ou Apache, qui nécessitent des fichiers de configuration statiques et des rechargements manuels, Traefik a été conçu pour la dynamicité du cloud. Il s'interface directement avec le socket Docker pour détecter en temps réel le démarrage et l'arrêt des conteneurs, adaptant sa configuration de routage instantanément: Hot Reload.

4.1. Configuration Hybride : Statique et Dynamique

Traefik v3 introduit une distinction claire entre deux types de configurations, essentielle à comprendre pour maîtriser l'outil :

- Configuration Statique : Définie au démarrage (via traefik.yml ou les arguments de commande CLI). Elle établit les connexions aux infrastructures (Docker, Let's Encrypt) et définit les points d'entrée (EntryPoints). Elle ne peut pas être changée sans redémarrer Traefik.

- Configuration Dynamique : Définie par les applications elles-mêmes (via les labels Docker). Elle contient les règles de routage (Host, Path), les middlewares et les services.

Dans notre cas, nous configurerons Traefik pour :

- Écouter sur les ports 80 et 443.

- Interroger le démon Docker pour découvrir les services.

- Ne pas exposer les services par défaut (exposedByDefault: false), obligeant une activation explicite via un label, une mesure de sécurité cruciale pour éviter d'exposer accidentellement des conteneurs internes.

4.2. Stratégie SSL : Le Wildcard et le DNS Challenge

L'exigence utilisateur est précise : un domaine wildcard (*.mondomaine.com) pointant vers l'IP du serveur, avec gestion automatique des certificats SSL.

La méthode de validation standard de Let's Encrypt, le HTTP-01 Challenge (qui place un fichier sur le serveur web), ne permet pas de délivrer des certificats wildcard.

Pour obtenir un certificat couvrant *.mondomaine.com, l'autorité de certification (Let's Encrypt) exige une preuve de contrôle sur la zone DNS elle-même : c'est le DNS-01 Challenge.

4.2.1. Le Mécanisme du DNS Challenge

- Traefik initie une demande de certificat pour *.mondomaine.com.

- Let's Encrypt fournit un jeton (token) unique.

- Traefik utilise l'API de votre fournisseur DNS (OVH, Scaleway, Cloudflare, AWS Route53, etc.) pour créer un enregistrement TXT temporaire nommé _acme-challenge.mondomaine.com contenant ce jeton.

- Let's Encrypt interroge les serveurs DNS publics pour vérifier la présence de cet enregistrement.

- Une fois validé, le certificat est délivré, et Traefik supprime l'enregistrement TXT.

4.2.2. Avantages Décisifs

Outre la capacité de générer des Wildcards, cette méthode présente un avantage de sécurité majeur : elle ne nécessite aucun port entrant ouvert. Un serveur situé derrière un NAT strict ou un pare-feu d'entreprise, sans port 80 ouvert, peut tout de même obtenir un certificat SSL valide tant qu'il a un accès sortant à l'API DNS.

4.3. Gestion du Trafic non-HTTP (TCP/UDP)

L'une des forces de Traefik v3 est sa capacité à router non seulement le trafic HTTP/HTTPS, mais aussi n'importe quel flux TCP ou UDP brut. C'est indispensable pour héberger des services comme des serveurs de jeux, des bases de données exposées (avec précaution), ou des protocoles IoT (MQTT).

Pour router du TCP/UDP, nous définissons des EntryPoints supplémentaires dans la configuration statique de Traefik (par exemple :25565 pour Minecraft) et utilisons le routeur HostSNI('*') pour le TCP (si pas de TLS) ou HostSNI('db.mondomaine.com') (si TLS est activé), car le protocole TCP brut ne transporte pas d'en-tête "Host" comme le HTTP.

5. Observabilité et Maintenance Proactive

Une infrastructure n'est pas une entité statique ; elle vit, génère des logs et nécessite des mises à jour.

5.1. Surveillance des Logs

L'accès SSH étant restreint et fastidieux pour une consultation rapide, je vous propose de déployer Dozzle, un visualiseur de logs léger en temps réel. Il se connecte au socket Docker et offre une interface web fluide pour voir les sorties standard (stdout/stderr) de tous les conteneurs.

Comme pour le dashboard Traefik, Dozzle doit être protégé par un middleware d'authentification (BasicAuth ou Authelia/Authentik pour une intégration SSO plus poussée) via les labels Traefik.

5.2. Mises à Jour Automatisées

La sécurité passe par la mise à jour constante des images Docker. Watchtower est l'outil de référence pour automatiser ce processus. Il surveille les registres d'images et, lorsqu'une nouvelle version est détectée, il télécharge l'image et redémarre le conteneur avec les mêmes options.

Cependant, en production, l'automatisation totale est risquée (une mise à jour majeure peut casser la base de données). Je vous recommande plutôt de configurer Watchtower en mode "Notification Uniquement" ou de restreindre les mises à jour automatiques aux correctifs mineurs via des tags précis (ex: mariadb:10.6.15 plutôt que mariadb:latest). Watchtower peut envoyer des notifications via email, Discord ou Gotify pour informer l'administrateur qu'une mise à jour est disponible.

5.3. Sécurité Active : Fail2Ban et Traefik

Traefik gère le trafic mais ne bloque pas intrinsèquement les attaques malveillantes répétées. L'intégration de Fail2Ban est essentielle pour bannir les adresses IP effectuant des scans agressifs ou des tentatives de login échouées.

En configurant Traefik pour écrire ses logs d'accès dans un fichier partagé ou en utilisant le plugin Traefik Fail2Ban, on peut détecter les erreurs 401/403 répétées. Fail2Ban interagit ensuite avec UFW ou directement avec iptables (dans la chaîne DOCKER-USER) pour bloquer l'IP attaquante au niveau du réseau, avant même qu'elle n'atteigne à nouveau Traefik.

6. Conclusion : Vers une Infrastructure Résiliente

L'architecture que je vous ai présenté dans ce rapport ne se contente pas de faire fonctionner des services. Elle propose une structure industrielle, que j’ai éprouvée et améliorée ces 10 dernières années dans les différentes startup où j’ai travaillé. En combinant la robustesse de Debian, la souplesse de Docker Compose, l'intelligence de Traefik v3 et une segmentation réseau rigoureuse, nous obtenons une plateforme qui respecte les plus hauts standards de sécurité moderne.

Cerise sur le gâteau pour les développeur, agence, ESN, PME, avec une tel architecture et un runner Gitlab ou Github, vos dev font un `git push` et le site ou la démo sont en ligne quelques minutes plus tard (si les tests sont verts évidemment 😀)

Cette pile technique offre une réponse élégante au trilemme de l'auto-hébergement :

- Sécurité : Assurée par le principe du moindre privilège (UFW, SSH Keys, Réseaux isolés).

- Simplicité : Garantie par l'automatisation SSL (DNS Challenge) et la configuration déclarative (Docker Compose).

- Flexibilité : Permise par la découverte dynamique de services de Traefik, capable de gérer du HTTP, du TCP et de l'UDP sans reconfiguration manuelle.

Adopter cette architecture, c'est choisir de construire sa maison numérique sur des fondations de béton armé plutôt que sur du sable mouvant, garantissant pérennité et sérénité pour vos données souveraines.